·麻省理工学院计算机科学与人工智能实验室(CSAIL)研究团队发现,多个语言模型协同工作胜过单一模型,多个AI协作有助于提高大型语言模型的推理能力和事实准确性。

·每个语言模型都生成对给定问题的回答,然后整合来自其他代理的反馈,以更新自己的回应。最终,多个模型的解决方案通过投票达成一致的最终输出。这一过程有点像小组讨论。

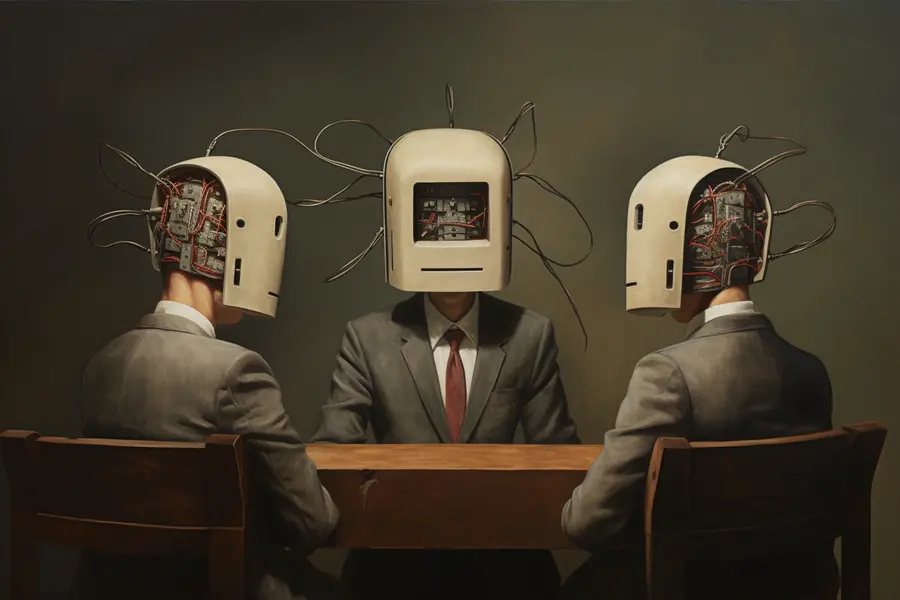

一种新颖的方法允许多种语言模型进行协作,经过多轮辩论,最终得出统一且精确的响应。/图片来源:Alex Shipps/MIT CSAIL,来自Midjourney

当地时间9月18日,麻省理工学院计算机科学与人工智能实验室(CSAIL)的团队在其官网更新了一项研究:发现多个语言模型协同工作胜过单一模型,多个AI协作有助于提高大型语言模型的推理能力和事实准确性。

俗话说“三个臭皮匠,顶个诸葛亮”。简单而言,这项研究利用多个AI系统互相协作,以协商、辩论的方式以达成对给定问题的最佳答案。这种方法提高了大语言模型对事实数据的依从性和改进决策的能力。

大型语言模型(LLM)长期存在的问题之一是,其生成的回答不一致,可能有不准确和错误的推理。而新方法允许每个智能体(agent)积极评估其他智能体的回答,并利用这些集体反馈来完善自己的回答。

这一过程包括多轮的回应生成和批判,每个语言模型都生成对给定问题的回答,然后整合来自其他代理的反馈,以更新自己的回应。最终,多个模型的解决方案通过投票达成一致的最终输出。这一过程有点像小组讨论,个体一起努力达成一致和合理的结论。

这一技术的一个显著优点在于,它可以无缝应用于现有的“黑匣子”模型(指难以知晓其内部运行过程),因为这个方法基于生成出的文本,而无需明晰其内部工作原理。CSAIL团队表示,这种简化可以帮助研究人员和开发者改进各种语言模型输出的一致性和事实准确性。

“我们不仅仅依赖于单一的AI模型来提供答案,相反,我们让众多的AI模型参与,每个模型都带来独特的见解以解决问题。尽管它们的初始回应可能显得简单或包含错误,但这些模型可以通过审查其同行提供的回应来改进和提高自己的回答。”麻省理工学院电气工程和计算机科学博士生、CSAIL附属成员以及论文的首席作者之一Yilun Du说道。

根据Yilun Du的个人主页,他目前正在攻读博士,此前已获得麻省理工学院学士学位,曾在ChatGPT的开发机构OpenAI担任研究员,在Facebook人工智能研究所(FAIR)和Google Deepmind担任实习生和访问研究员,并在国际生物奥林匹克竞赛中获得金牌。有趣的是,他曾在TED发表题为《为什么机器人需要梦想》的演讲。

“当这些AI模型参与对话和思考时,它们更能够识别和纠正问题,增强解决问题的能力,并更好地验证其回应的准确性。基本上,我们正在创造一种迫使它们深入问题核心的环境。这与单一的孤立的AI模型形成对比,后者经常复制互联网上找到的内容。然而,我们的方法积极刺激了AI模型制定更准确和全面解决方案的能力。”Yilun Du说。

此项研究涉及数学问题的解决,包括小学和初高中的数学问题,并通过多智能体辩论显著提高了性能。该方法还可以帮助解决经常困扰大语言模型的“幻觉”问题。通过设计这样的环境,智能体之间可以批判对方的回应,更有动力避免随机生成信息并优先考虑事实准确性。

除了应用于语言模型,该方法还可以用于整合具有专门能力的不同模型。通过建立一个多智能体相互交互和辩论的去中心化系统,它们可以潜在地在语音、视频或文本等各种模式下提高问题解决能力。不过研究人员表示,当处理非常长的上下文时,现有的语言模型可能面临挑战,批判能力可能表现得不如预期。