昨天我们提到英伟达发布超强AI计算平台DGX GH200,很多人关注该款超级计算机对光模块需求影响的程度。

根据多家券商的测算情况,市场普遍认为光模块的用量还是呈现较大幅度的提高。新架构全光方案GPU:800G光模块数量比1:18,半光方案GPU:800G光模块数量比1:9。

具体来看,每个Node单向带宽450GB/s(900GB/s双向带宽),8颗Superchip累计3.6TB/s单向带宽,800G光模块实际传输能力为100GB/s,即一个Node单向传输需要36个800G光模块,全系统共2个上行方向+2个下行方向,累计需要144个800G光模块(对应8颗Superchip),即800G全光方案比例关系为1:18。类似的,400G全光方案比例关系为1:36,800G半光方案比例关系为1:9。

除模块之外,见智研究认为:还应关注内存和PCB的增量价值。

GH200单颗芯片需要480GB LPDDR5内存+96GB的HBM显存。而上一代DGX H100服务器中,平均单颗H100芯片对应256GB内存,以及80GB的HBM。二者对比,GH200方案的存储器价值量有显著提升。

PCB:传统服务器中,主板单价近5000元/平米;加速卡板单价更高,随着层数、材质、加工难度的提升,可达1w+/平米。

GH200超级芯片是CPU+GPU二合一,集成度提升可以省去部分主板PCB,但相较传统加速卡面积更大,同时要在加速卡板材质、层数、HDI等方面进一步升级。

2、出现了比Meta更好的开源大模型?

一款名为FalconLM 开源语言模型说是提供了比 Meta 的 LLaMA 更好的性能,是迄今为止最强大的开源语言模型。

该款模型是由阿拉伯联合酋长国阿布扎比的技术创新研究所 (TII) 开发,FalconLM 最大的变体拥有400亿个参数,可以用于商业。但如果收入超过100万美元,则商业用途需要缴纳特许权使用费。在总结各种基准测试结果的Hugging Face OpenLLM 排行榜上,两个最大的 FalconLM 模型(其中一个已经用指令进行了改进)目前以显着优势占据前两名。

见智研究认为:开源语言模型如雨后春笋般的冒出,部分基础大模型的性能也表现出较强的优势。FalconLM相较于其他开源模型的竞争优势的包括在训练数据的选择,从公共爬网数据集中提取高质量数据并删除重复数据的流程。在彻底清除重复数据后,仍保留了5万亿条文本(token)——足以训练强大的语言模型。此外, FalconLM优化后的架构能够很大程度提高计算能力,推理成本仅为GPT3的五分之一。

国内AI

政策鼓励加强算力的部署和分配,还应该关注数据中心上架率

北京市政府办公厅正式发布《北京市促进通用人工智能创新发展的若干措施》,主要包括五大方面:1、提升算力资源统筹供给能力;2、提升高质量数据要素供给能力;3、系统构建大模型等通用人工智能技术体系;4、推动通用人工智能技术创新场景应用;5、探索营造包容审慎的监管环境。

见智研究认为:在政策的推动下,算力、数据要素市场将会进一步得到全面的效率优化和监管,会给民营企业在租用算力上来带便捷度,从而促进行业的良性发展。

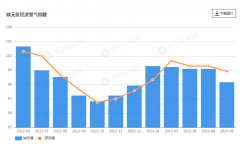

从基础设施方面来看,AI新基建主要会围绕数据中心、超算中心的建设以及配套设备需求提高,具体包括AI服务器、高速交换机、光模块、制冷设备、电源设备等。应用场景方面鼓励创新同样会正向刺激算力的需求。但仍需关注数据中心目前机架上机率的情况,是否已经达到较高水平。